Hast du bei aller Begeisterung für die Möglichkeiten, die KI bietet, schon mal an den Datenschutz gedacht? Oder hast du einfach "alles ausprobiert", was dir so "über den Weg gelaufen ist"? Was mich beim Thema KI und Datenschutz am meisten irritiert ist, dass es so selten thematisiert wird. Und das, obwohl wir z.B. bei Event-Management-Tools, Interaktionstools oder Videokonferenz-Tools ganz genau hinsehen und unsere ITler und Datenschützer jeden Stein umdrehen, um die DSGVO-Konformität zu prüfen.

Die DSGVO gilt für alle digitalen Lösungen

Egal, welche Tools oder digitalen Lösungen wir einsetzen, die DSGVO ist für uns maßgebend. Das sollten wir uns beim Einsatz von KI-Tools immer wieder vor Augen führen und dort die gleichen Maßstäbe ansetzen wie für andere Tools. Wenn du also bei einer Videokonferenz-Lösung, Event-Plattform oder einem Votingtool genau schaust und fragst, wo der Anbieter sitzt, wo die Daten gehostet werden und ob der Server wirklich nicht von AWS stammt, musst du auch bei einer KI-Lösung wenigstens mal schauen, ob du überhaupt ein Impressum findest. Und den Rest natürlich auch prüfen.

Ist ChatGPT DSGVO-konform?

Expert·innen sagen, dass der DSGVO-konforme Einsatz von ChatGPT bisher nicht möglich sei. Zum einen mangelt es an Transparenz für die User und zum anderen fehlen noch die gesetzlichen Grundlagen – dafür gibt es allerdings inzwischen einen Vorschlag für ein Gesetz, den "Artificial Intelligence Act".

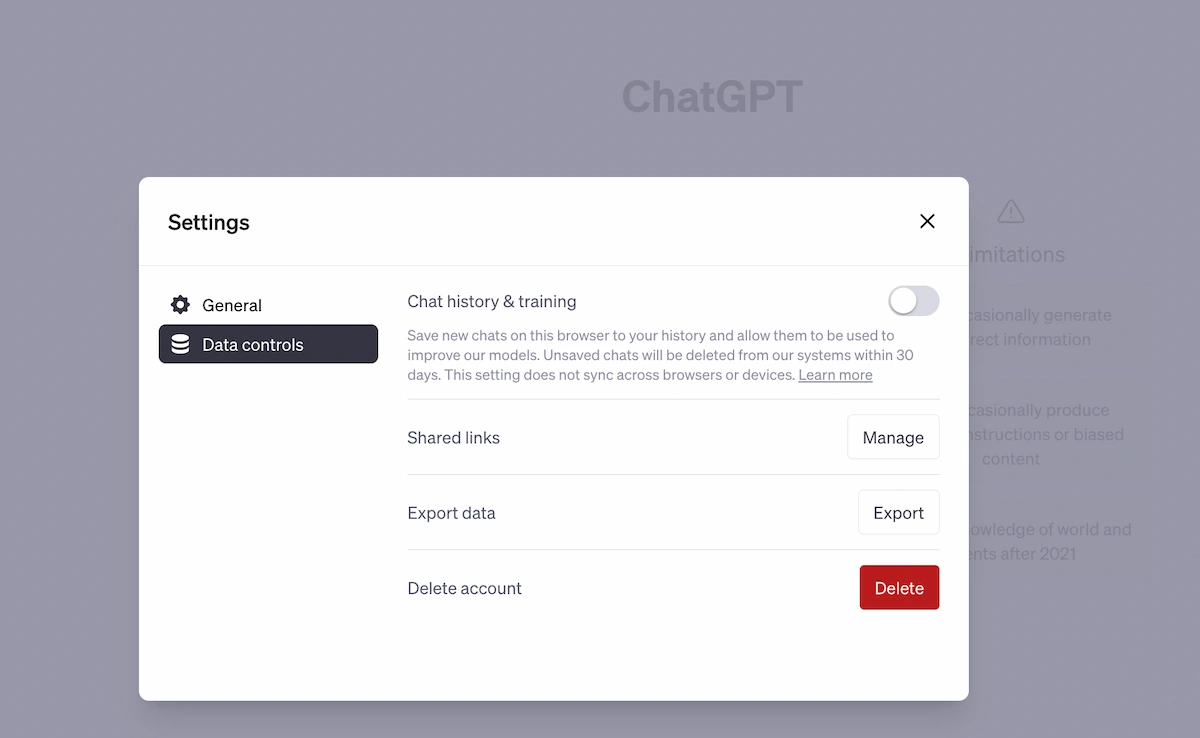

Du kannst übrigens in den Einstellungen von OpenAI ChatGPT deaktivieren, dass deine Daten als Trainingsdaten für die KI genutzt werden.

Risiko und Datensicherheit in bestimmten Fachgebieten

Im Kern geht es bei der Datensicherheit bei der Nutzung von KI um zwei Bereiche. Zum einen um den Schutz der eingegebenen Daten und zum anderen um den der entstandenen Daten und was mit diesen passiert.

Doch bevor du nun KI verteufelst, ist es wichtig, dass du das Risiko in verschiedenen Bereichen besser abschätzen kannst.

Im Marketing kannst du vor allem für die Content-Produktion KI-Tools als Inspirationsquelle nutzen. Gibst du keine personenbezogenen Daten ein, ist das Risiko des Datenmissbrauchs gering. Nutzt du jedoch echte User-Daten, solltest du diese zuvor anonymisieren.

In der Softwareentwicklung kannst du dir von KI auch Code generieren lassen. Wichtig ist, dass du dabei keine Daten aus eurem Unternehmen der KI verrätst und somit das Geschäftsgeheimnis verletzt.

Lässt du es zu, dass im Service- und Kunden-Support personenbezogene und sensible Daten, wie z.B. Kundendaten und Zahlungsinformationen, von der KI verarbeitet werden, gehst du ein hohes Datenschutz-Risiko ein. Expert·innen raten eher davon ab, KI hier zu nutzen – zumindest solange, wie die Standards noch so unklar und verbesserungswürdig sind.

In der HR-Abteilung und im Recruiting wird es immer dann riskant, wenn sensible Daten wie Gesundheitsdaten oder Bankverbindungen und ähnliches ausgetauscht werden. Außerdem kann es passieren, dass KI diskriminierende Entscheidungen trifft, beispielsweise weil sie mit unzureichenden oder falschen Daten trainiert wurde. Schau dazu auch nochmal in die Übersicht von Professor Arvind Narayanan im Blogbeitrag AI Tools fürs Event-Management & Marketing.

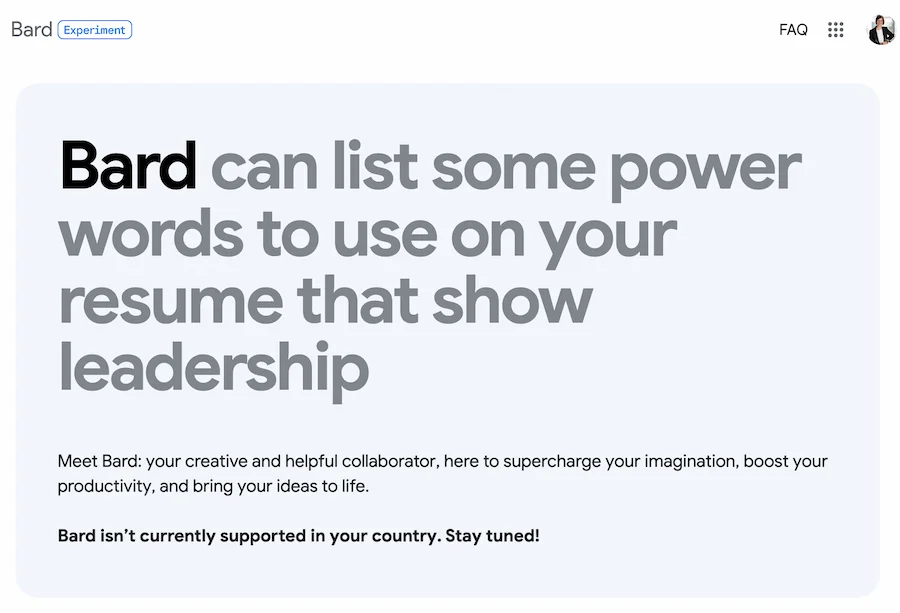

DSGVO hält Googles KI-Lösung Bard zurück

Vielleicht hast du es mitbekommen: Die KI-Lösung von Google, Bard, ist zwar nun auch in 180 Ländern verfügbar, allerdings kommst du bislang mit einer deutschen IP-Adresse da noch nicht rein. Grund: Die DSGVO. Wovor Google (noch) zurückschreckt, hält andere Anbieter derzeit nicht davor zurück, ihren Dienst auch in Europa bzw. dem DACH-Raum anzubieten.

So steht es um KI-Modelle mit Blick auf das EU-KI-Gesetz

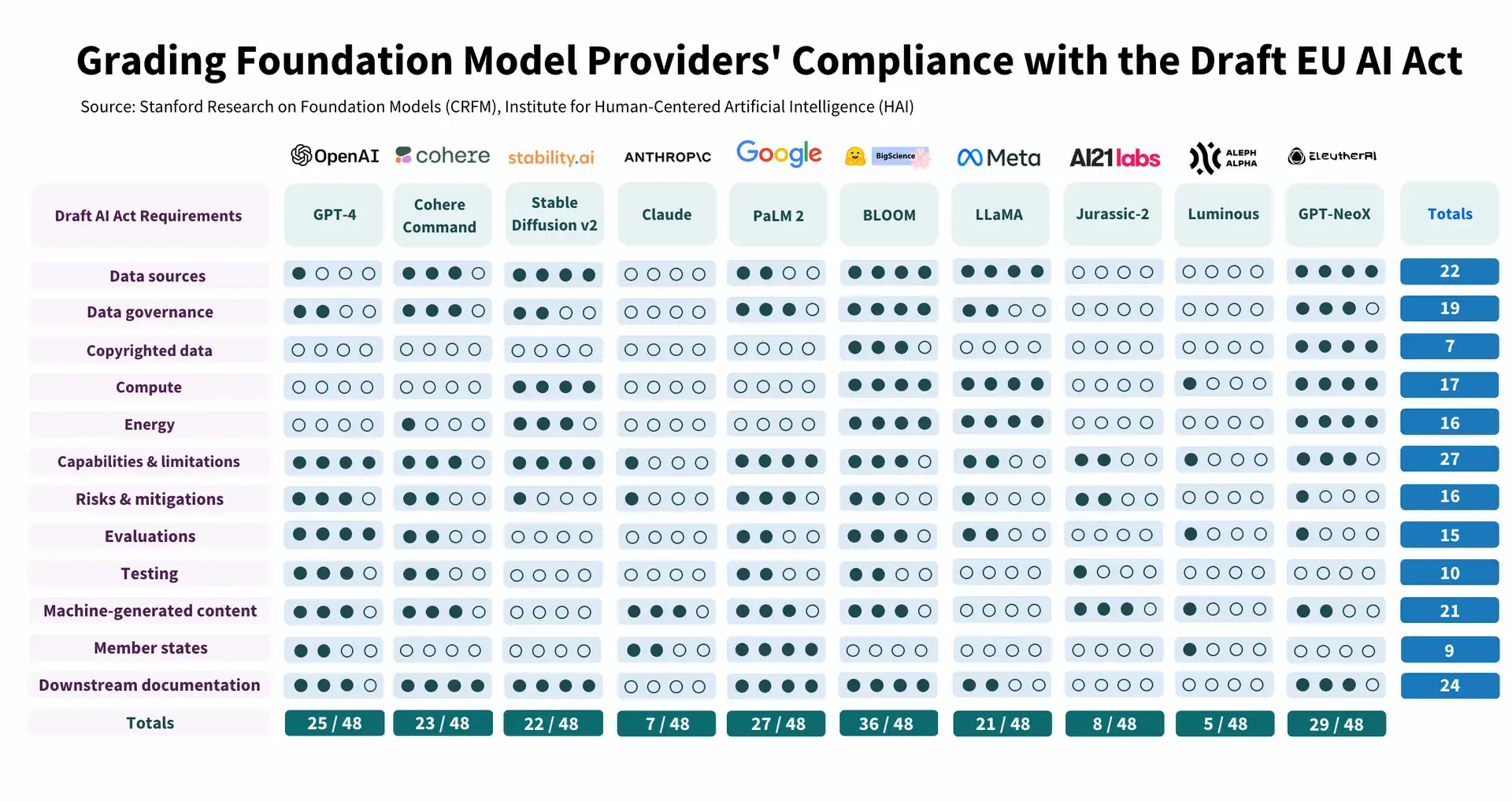

Wusstest du, dass das Human-Centered AI Institute in Stanford die Konformität von zehn KI-Modellen mit dem EU-Gesetzentwurf für KI untersucht hat? Es kam zu dem Ergebnis, dass die KI-Anbieter noch einen ganzen Weg gehen müssen, bis sie die Anforderungen des Gesetzesentwurfs erfüllen. Die Studie identifizierte 22 Anforderungen und bewertete die Konformität in den Kategorien Daten, Datenverarbeitung, Modell und Anwendung. Das KI-Gesetz der EU soll 2024 in Kraft treten.

Die Studie bzw. die Abbildung zeigt, eine große Bandbreite bei der Einhaltung der Vorschriften durch die Modellanbieter. Einige erreichen weniger als 25 Prozent und lediglich ein einziger Anbieter erreicht derzeit 75 Prozent und auch hier gibt es noch erheblichen Spielraum für Verbesserungen. Dies lässt vermuten, dass das Gesetz, wenn es in Kraft tritt, das Ökosystem KI-Modelle noch erheblich verändern und mehr Transparenz und Rechenschaftspflicht bewirken würde.

In diesen vier Bereichne gibt es noch enormes Verbesserungspotenzial:

- urheberrechtlich geschützte Daten,

- Computer/Energie,

- Risikominderung,

- Bewertung/Tests.

Unklare Haftung aufgrund des Urheberrechts

Nur wenige Anbieter geben Auskunft über den Urheberrechtsstatus der Trainingsdaten. Viele Stiftungsmodelle werden auf Daten trainiert, die aus dem Internet kuratiert wurden und von denen ein beträchtlicher Teil wahrscheinlich urheberrechtlich geschützt ist. Die rechtliche Zulässigkeit des Trainings mit diesen Daten bleibt unklar.

Uneinheitliche Berichterstattung über den Energieverbrauch

Die Anbieter der Modelle machen uneinheitliche Angaben zum Energieverbrauch, zu den Emissionen, zu ihren Strategien zur Messung der Emissionen und zu den Maßnahmen, die sie zur Verringerung der Emissionen ergriffen haben.

Unzureichende Offenlegung der Risikominderung/Nichtminderung

Das Risiko für die Modelle ist immens und umfasst viele Formen der böswilligen Nutzung, unbeabsichtigte Schäden und strukturelle oder systemische Risiken. Während viele Anbieter Risiken aufzählen, legen relativ wenige die von ihnen getroffenen Abhilfemaßnahmen und deren Wirksamkeit offen.

Fehlen von Bewertungsstandards/einem Ökosystem für Audits

Die Anbieter der KI-Modelle messen nur selten die Leistung der Modelle in Bezug auf absichtliche Schäden wie böswillige Nutzung oder Faktoren wie Robustheit und Kalibrierung. Standards für die Evaluierung von Modellen sind noch in Arbeit.

> zur KI-Studie des Human Centered AI Institutes

> zum Entwurf des Artificial Intelligence Act der EU

Das könnte dich auch interessieren: